Ollama下载的模型存放位置取决于操作系统和用户的自定义设置在Windows系统中llama下载文件,默认情况下,Ollama的模型会下载并存放在CUserslt用户名ollamamodels目录下例如,如果用户名是Smqnz,那么模型文件默认存放路径就是C对于Ubuntu系统,默认的Ollama模。

本地部署Llama 3模型使用Ollama进行本地部署,快速安装并下载Llama 3模型文件,如最新8B版本,文件大小约47G通过Ollama命令窗口或模型库中的pull命令,实现模型文件的下载使用Ollama进行聊天对话功能测试,体验模型交互效果。

首先,通过提交申请至 Meta 的 Llama 下载页面,您将获得包含下载链接的邮件确保在 Linux 环境下运行 repo 中的 downloadsh 脚本若在 Windows 下执行该脚本会报错,原因是 Windows 与 Linux 的换行符格式不同解决方法是使用 VSCode 等编辑器将文件换行符格式从 Windows 的 CRLF\r\n更改为。

获取 LLaMA 权重并转成 Hugging Face Transformers 模型格式,首先需要登录 LLaMA 官方网站,并点击下载按钮进入下载界面之后,根据提示填写相关信息以获取下载链接使用官网提供的 downloadsh 脚本,通过粘贴链接并输入所需版本号,即可下载模型下一步是模型 Hugging Face 化原始 LLaMA 权重文件无法直。

如果Ollama下载模型失败,llama下载文件你可以尝试以下几个解决步骤检查网络连接确保你的网络连接是稳定的下载大型模型文件需要稳定的网络连接,如果网络不稳定或速度过慢,可能会导致下载失败检查存储空间确认你的设备上有足够的存储空间来保存模型文件如果存储空间不足,下载过程可能会失败尝试重启应用或设备。

如果Ollama下载模型失败,可以尝试以下几个解决方法首先,检查一下你的网络连接是否稳定下载大型模型文件需要稳定的网络环境,如果网络不稳定或者速度过慢,可能会导致下载失败你可以尝试重启路由器或者更换网络环境,看看是否能够解决问题其次,确认一下你的设备是否有足够的存储空间模型文件通常都比较。

HuggingFace已发布Llama的hf版本,可以直接使用以下是LLama2模型原始权重获取和转换脚本的介绍通过MetaAI审核后,会收到包含PRESIGNED_URL的邮件执行downloadsh脚本,按提示操作即可下载运行downloadsh脚本代码注释 脚本运行步骤 下载后的rawllama27b文件夹包含模型权重文件转换后得到的llama2_。

首先,用户需要打开Ollama官网,并点击页面右上角的ldquoDownloadrdquo按钮然后,根据自己的电脑系统版本,选择合适的安装包进行下载下载完成后,双击安装包并按照提示完成Ollama的安装安装完成后,用户需要通过命令提示符或终端来运行DeepSeek在命令提示符或终端中输入ldquoollama run deepseek。

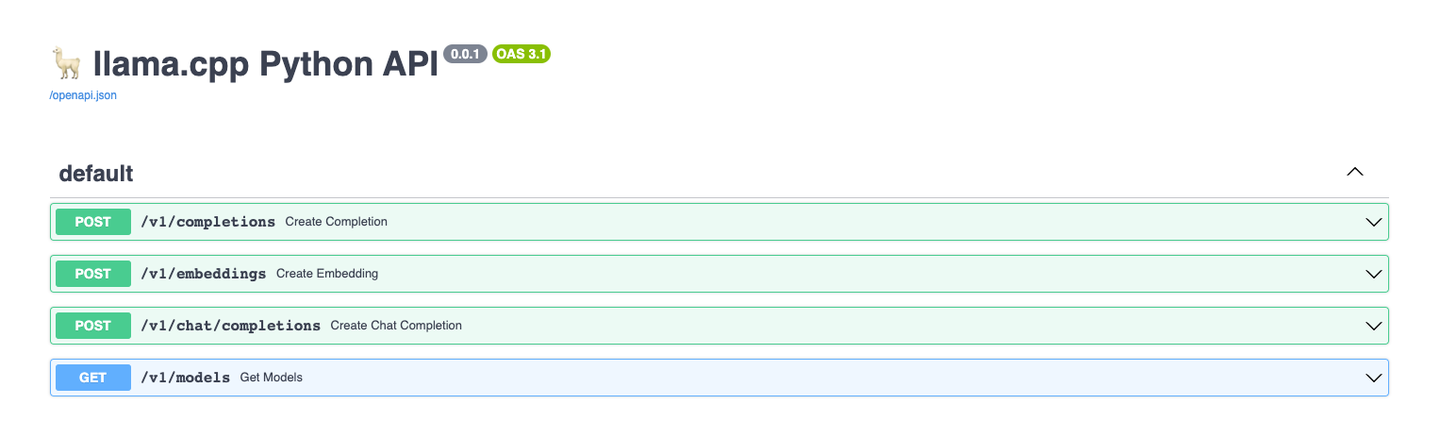

下载模型时,Ollama提供了内置模型,但选项有限从HuggingFace下载则更灵活,搜索llama3,设置Languages为Chinese,可以找到多种基于LLaMa3的中文模型从HuggingFace下载GGUF格式的模型文件,选择q6模型质量高并下载下载文件后,创建一个配置文件如configtxt,指定模型文件路径,并使用命令导入模型。